C2-IA-04 : Réseau de neurones artificiels#

Objectifs pédagogiques#

connaître les bases du modèle de neurone artificiel

savoir citer les constitutifs d’un neurone artificiel

connaître les constitutifs d’un réseau de neurones artificiels

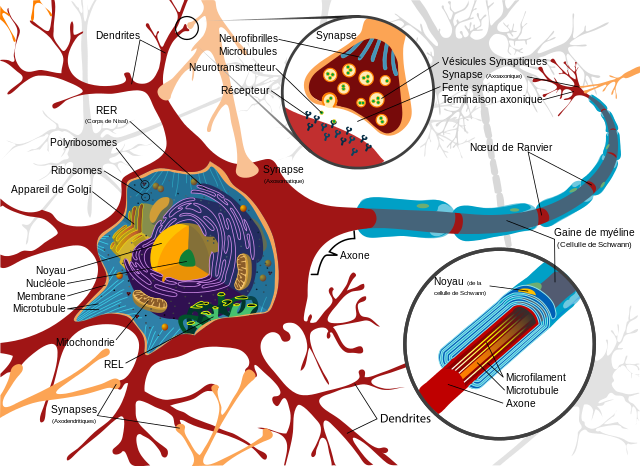

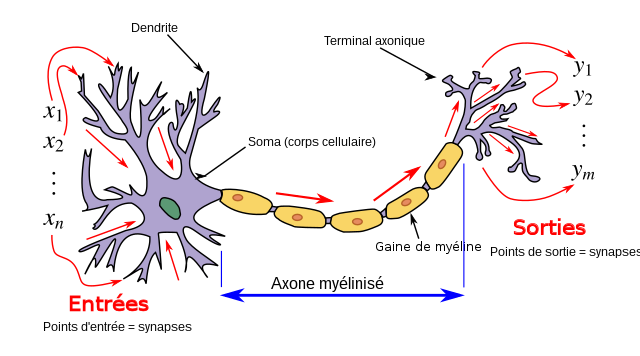

Neurone biologique#

Le point de départ des travaux sur le Perceptron de McCulloch et Pitts sont le neurone biologique, soit la brique fondamentale, l’unité fonctionnelle de base constitutive du système nerveux central.

Celui-ci est constitué principalement de :

un noyau cellulaire

un axone (émetteur) : c’est lui qui conduit le signal électrique vers les synapses

des synapses : c’est le lien entre deux neurones

des dentrites (récepteurs) : c’est eux qui conduisent le signal reçu vers le noyau du neurone

Un système nerveux central (un cerveau) n’est donc rien de plus qu’un ensemble de neurones interconnectés entre eux.

(pour plus de détails, voyez votre cours de biologie)

Modèle de neurone biologique#

Un modèle d’un objet, d’un phénomène ou d’un concept est une représentation mathématique qui l’imite. Le modèle doit imiter les traits les plus importants de l’objet que l’on souhaite modéliser. Les détails de fonctionnement sont laissés de côté.

Un neurone biologique est constitué d’un noyau, de synapses, axone et dentrites, eux-même constitués de membranes, de matériel génétique (ADN), et des éléments constitutifs des cellules. Chaque élément constitutif des cellules et constitué de molécules (biomolécules) comme les lipides, glucides, protéines et acide nucléique. Toutes ces molécules sont constituées d’atomes, eux-même constitués de protons, de neutrons et d’électrons, eux-mêmes constitués de quarks.

Si l’on veut représenter le fonctionnement macroscopique d’un neurone, alors il est impossible de modéliser l’entier du fonctionnement. On se concentre donc sur le fonctionnement du neurone.

C’est ce que l’on appelle un modèle de neurone biologique.

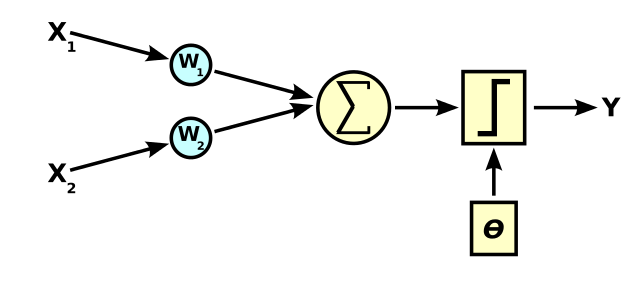

Le modèle de neurone biologique le plus simple est le neurone formel (ou neurone de McCulloch et Pitts). Il est constitué de 5 éléments :

\(m\) entrées \(x_1, ..., x_m\)

\(m\) poids synaptiques \(\omega_1, ..., \omega_m\) associés aux \(m\) entrées et compris entre \([0 \leq \omega_i < 1]\)

une fonction de somme \(\sum_{i = 1}^m \omega_i x_i\)

un seuil \(\omega_0\) fixé à une valeur arbitraire généralement de \(1\).

une fonction d’activation du neurone \(\Phi\)

une valeur de sortie \(y\)

Les mathématiques nécessaires pour expliquer l’entier du neurone dépassent largement le cadre de ce cours d’informatique.

C’est ce modèle que l’on appelle neurone artificiel qui est utilisé dans les algorithmes d’apprentissage automatique.

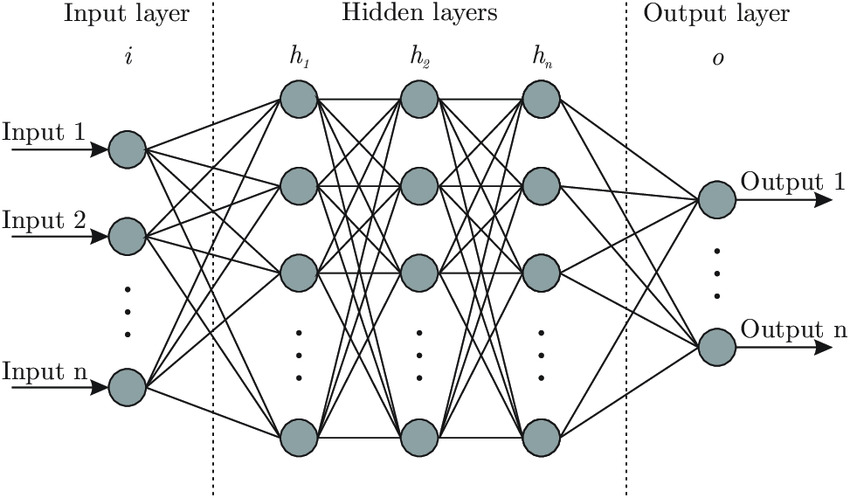

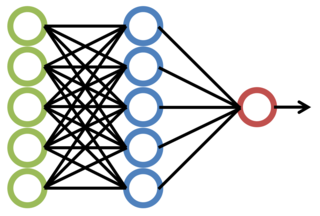

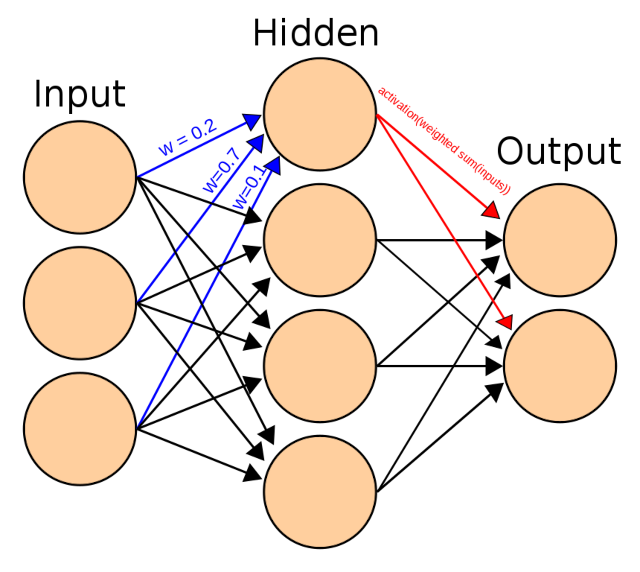

Réseau de neurones artificiels#

Une fois que le neurone est modélisé, on peut en connecter plusieurs ensembles. Les sorties des neurones deviennent les entrées d’autres neurones.

C’est ce que l’on appelle un réseau de neurones artificiels (Artifical Neural Network ou ANN en anglais).

Un réseau de neurones artificiels est constitué de :

entrées \(x_i\)

neurones cachés et interconnectés

sorties \(y_i\)

Apprentissage profond#

L’apprentissage profond (Deep Learning) est un sous-domaine de l’intelligence artificielle. L’apprentissage profond est apparu à la fin des années 2000 lorsque:

la puissance des ordinateurs a atteint ce qui était nécessaire pour exécuter des algorithmes complexes

les ensembles de données suffisamment représentatifs ont été collectés (de façon légale ou non)

ces mêmes ensembles de données étiquetés et leurs caractéristiques extraites.

On peut dire que l’équation Big Data + Large ANN + High Performance Computing = Deep learning représente bien l’apprentissage profond.

L’apprentissage profond utilise des réseaux de neurones artificiels étendus : le nombre de couches cachées est important.